ICLR 2024 — Шилдэг илтгэл, яриа (ImageGen, Vision, Transformers, State Space Models болон бусад сургалтын төлөөлөгчид) ft. Christian Szegedy, Ilya Sutskever, Durk Kingma

Илтгэгчид

AI инженер дэлхийн үзэсгэлэн

байсан

зарласан

! Манайхыг хар

Майкрософт анги

Дэлгэрэнгүй мэдээлэл авах болон

одоо худалдаж аваарай

кодтой

ХОЛБООТОЙ

1

— бид хиймэл оюун ухааны салбарын хамгийн сайн итгэлийг бий болгохын тулд ML-ийн шилдэг судалгааны бага хурлыг судалж байна!

Энэ жил өдөрт 4 үндсэн зам, олон арван семинар/эпо сесс байгааг анхаарна уу; Үнэгүй шууд дамжуулалт энэ удаад агуулгын талаас хамаагүй бага хувийг цацах болно.

Үнэгүй/хөнгөлөлт авах хүсэлт гаргах Олон талт байдлын хөтөлбөр болон Тэтгэлгийн тасалбар энд. Бид үүнийг бүх хиймэл оюун ухааны инженерүүдэд зориулсан техникийн эцсийн хурал болгоно гэж найдаж байна.

ICLR 2024 5-р сарын 6-11-ний хооронд Австри улсын Вена хотод болсон.

Яг л бид маш их алдартай болсон шигээ NeurIPS 2023 хамрах хүрээ, бид 900 долларын тасалбарыг төлөхөөр шийдсэн (та бүхний төлбөр төлж буй дэмжигчиддээ баярлалаа!) мөн та бүхний өмнөөс 18 цагийн нислэг, 5 өдрийн турш зоригтойгоор явахаар шийдсэн. Одоо бид энэ ажлын үр дүнг танилцуулж байна!

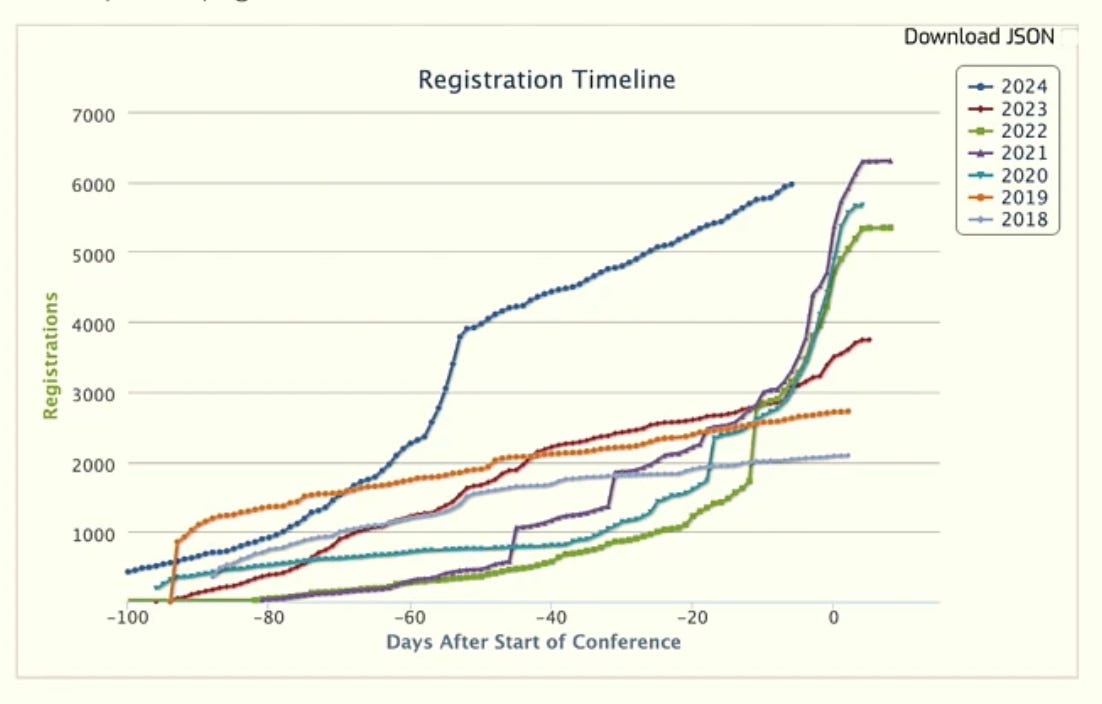

Энэхүү ICLR нь хурлын сэтгэл хөдлөлийн замд мэдэгдэхүйц өөрчлөлт оруулсан хамгийн том нь байв.

Хүлээн авсан 2260 баримт бичгийн (31% нь хүлээн авах хувь), манайтай холбоотой дэд багц AI инженерийн сэдвүүдийн жагсаалт , бид LLM-ийн олон, олон үндэслэл, агенттай холбоотой баримт бичгүүдийг олсон бөгөөд үүнийг дараагийн ангид авч үзэх болно. Бид энэ ангийг ICLR-ийн бусад холбогдох сэдвүүдийг хамарсан 14 нийтлэлтэй хамт өнгөрүүлэх болно.

Өнгөрсөн жилийнх шигээ бид үүнээс эхлэх болно Шилдэг цаасны шагналууд .Өнгөрсөн жилээс ялгаатай нь бид цаасан сонголтоо субъектив сэдвийн хүрээнд бүлэглэж, шилдэг илтгэлийн яриа болон редакцийн сонгосон зурагт хуудасны аль алинд нь хольж байна. Хэрэв бид зурагт хуудасны ярилцлага хийх боломжтой байсан бол тэдний зурагт хуудасны зургийг холбогдох шоуны тэмдэглэлээс гүйлгэж хэлэлцэнэ үү. Бүх зүйлийг хязгаарлахын тулд Крис Рэгийн өнгөрсөн жилийн цэг одоо Саша Раш руу очиж, Төрийн сансрын загваруудын хөгжил, хэрэглээний талаар заавал сүүлчийн үгийг хэлэх болно.

Бид ICLR 2024-д тэсрэлт хийсэн бөгөөд бид 2025 онд буцаж ирнэ гэдэгт та мөрийцөж болно.

Цагийн тэмдэг, баримт бичгийн тойм

[00:02:49] А хэсэг: Зураг, шахалт, сөргөлдөөний довтолгоо

-

[00:02:49] VAEs

-

[00:32:36] Вюрстхен: Том хэмжээний текстээс зураг хүртэлх тархалтын загварт зориулсан үр дүнтэй архитектур

-

[00:37:25] Тархалтын загваруудын далд хэл

-

[00:48:40] Илья шахалтын тухай

-

[01:01:45] Кристиан Сегеди шахалтын талаар

-

[01:07:34] Мэдрэлийн сүлжээний сонирхолтой шинж чанарууд

[01:26:07] Б хэсэг: Алсын хараатай суралцах ба сул хяналт

-

[01:26:45] Алсын хараа хувиргагчдад бүртгэл хэрэгтэй

-

[01:38:27] Ярихаасаа өмнө бод: Түр зогсоох тэмдэг бүхий хэлний загваруудыг сургах

-

[01:47:06] Сул хяналтан дор өгөгдөл сонгох статистикийн онол руу

-

[02:00:32] ImageNet 1 видео үнэ цэнэтэй юу?

[02:06:32] С хэсэг: Өргөтгөх трансформатор ба анхаарал

-

[02:06:49] LongLoRA: Урт контекст том хэлний загваруудын үр дүнтэй нарийн тохируулга

-

[02:15:12] YaRN: Том хэлний загваруудын үр дүнтэй контекст цонхны өргөтгөл

-

[02:32:02] Загвар өмсөгч танд юуг хаяхыг хэлж байна: LLM-д дасан зохицох KV кэшийн шахалт

-

[02:44:57] ZeRO++: Аварга загвар сургалтын маш үр дүнтэй хамтын харилцаа холбоо

[02:54:26] Хэсэг D: Төрийн сансрын загвар ба трансформаторууд

-

[03:31:15] Хэзээ ч зурааснаас сургадаггүй: Урт дарааллын загваруудын шударга харьцуулалт нь өгөгдөлд тулгуурласан өмнөх загваруудыг шаарддаг.

-

[03:37:08] 1-р хэсгийн төгсгөл

Х: ImageGen, шахалт, сөрөг довтолгоо

-

Дурк Кингма (OpenAI/Google DeepMind) болон Макс Веллинг : Автомат кодчилол Variational Bayes ( ICLR-ийн бүрэн яриа )

-

Урьдчилсан нөөц: VAE-г ойлгох , CodeEmporium , Arxiv Insights

-

Нээлтийн ICLR цагийн тестийн шагнал ! “Магадлалын загварчлал бол бидний ертөнцийг тайлбарлах хамгийн үндсэн аргуудын нэг юм. Энэхүү цаасыг тэргүүлсэн өргөтгөх боломжтой магадлалын дүгнэлттэй гүнзгий суралцах нэгдмэл байдал (Гэмтсэн дундаж талбайн хэлбэлзлийн дүгнэлт гэж нэрлэгддэг нөхөн сэргээх арга ), бий болгож байна Variational Autoencoder (VAE) .”

-

-

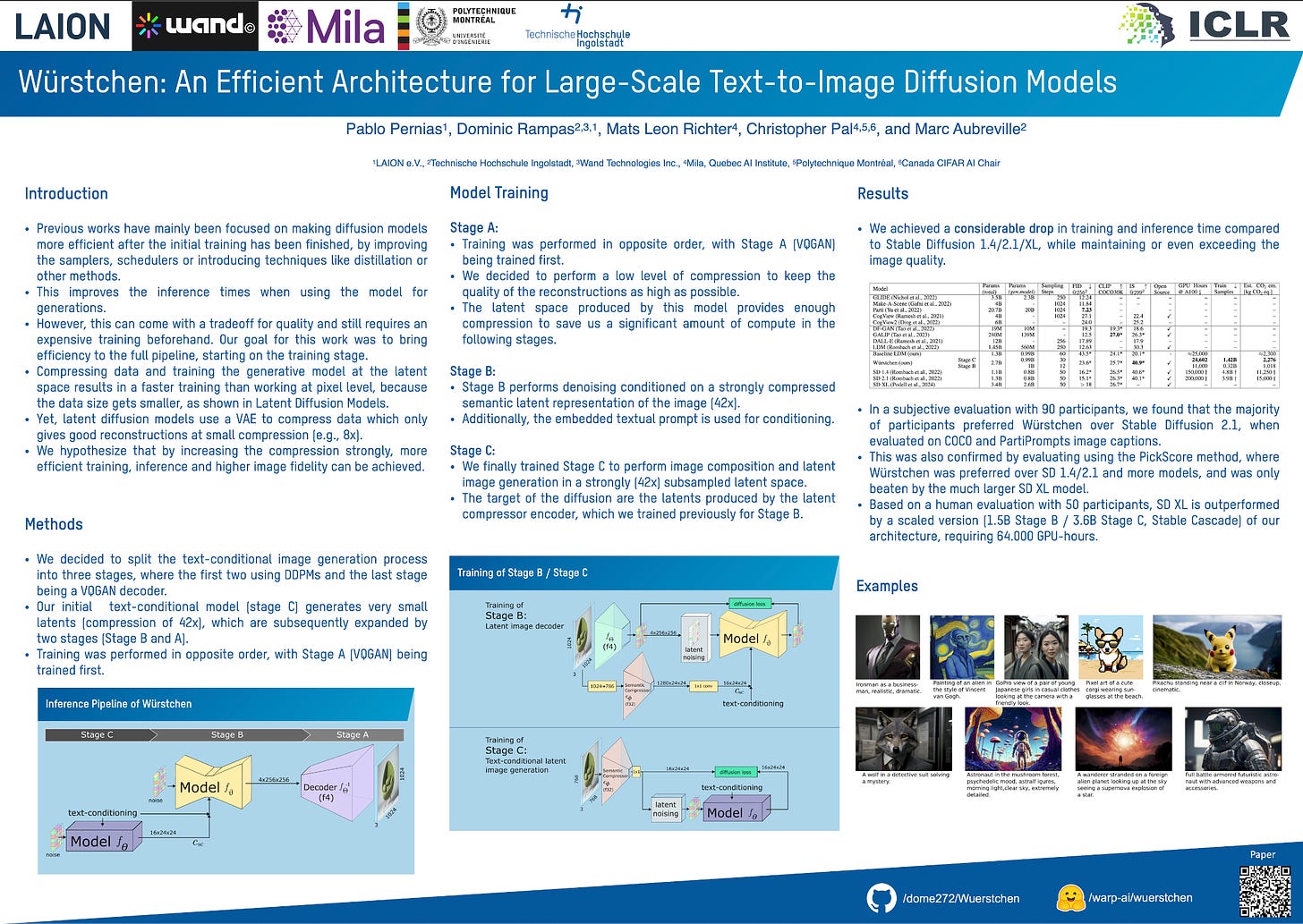

Пабло Перниас (Тогтвортой байдал) гэх мэт : Вюрстхен : Том хэмжээний текстээс зураг хүртэлх тархалтын загваруудад зориулсан үр дүнтэй архитектур ( ICLR аман , зурагт хуудас )

-

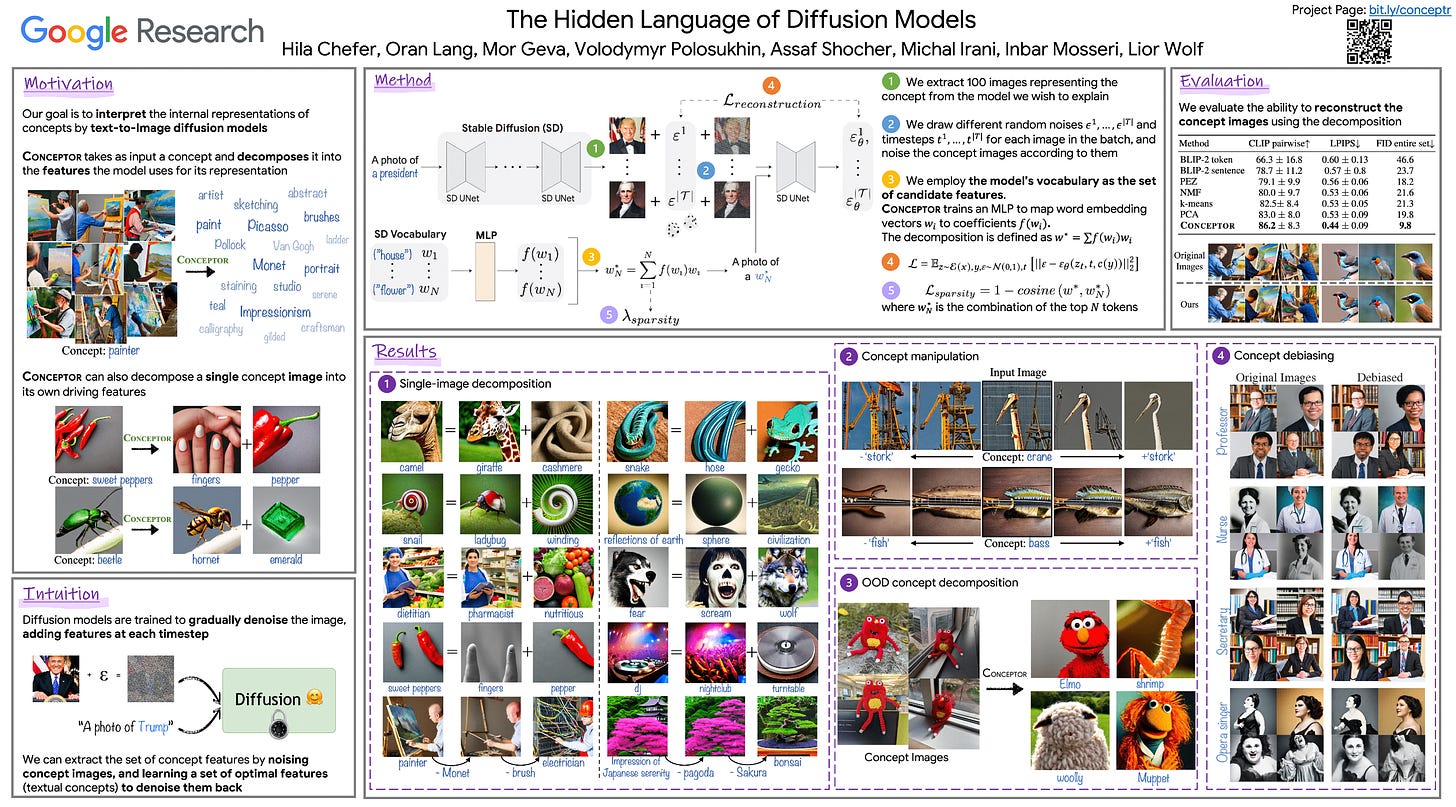

Hila Chefer et al (Google Research): Тархалтын загваруудын далд хэл ( зурагт хуудас )

-

Мөн үзнэ үү: Google Lumiere , Оролцоод сэтгэл догдлоорой

-

Кристиан Сегеди (X.ai): Мэдрэлийн сүлжээний сонирхолтой шинж чанарууд ( ICLR-ийн бүрэн яриа )

-

Анхны сорилтын цаг хугацааны шагналын дэд байр эзэлсэн : "Бодит хэрэглээнд гүн мэдрэлийн сүлжээнүүд улам бүр түгээмэл болж байгаа тул мэдрэлийн сүлжээ хэзээ, хэрхэн хүсээгүй байдлаар ажиллаж болохыг ойлгох нь чухал юм. Энэхүү баримт бичигт энэ асуудлыг онцолсон болно мэдрэлийн сүлжээ нь оролтын бараг үл мэдэгдэх жижиг өөрчлөлтөд өртөмтгий байж болно . Энэ санаа нь сөргөлдөөнтэй дайралт (мэдрэлийн сүлжээг хуурах гэж оролдох) болон сөрөг хамгаалалтыг (мэдрэлийн сүлжээг хуурахгүй байхыг сургах) бий болгоход тусалсан. "

-

хамт Войцех Заремба, Илья Сутскевер, Жоан Бруна, Думитру Эрхан, Иан Гудфеллоу, Роб Фергус

Б: Алсын хараатай суралцах ба сул хяналт

-

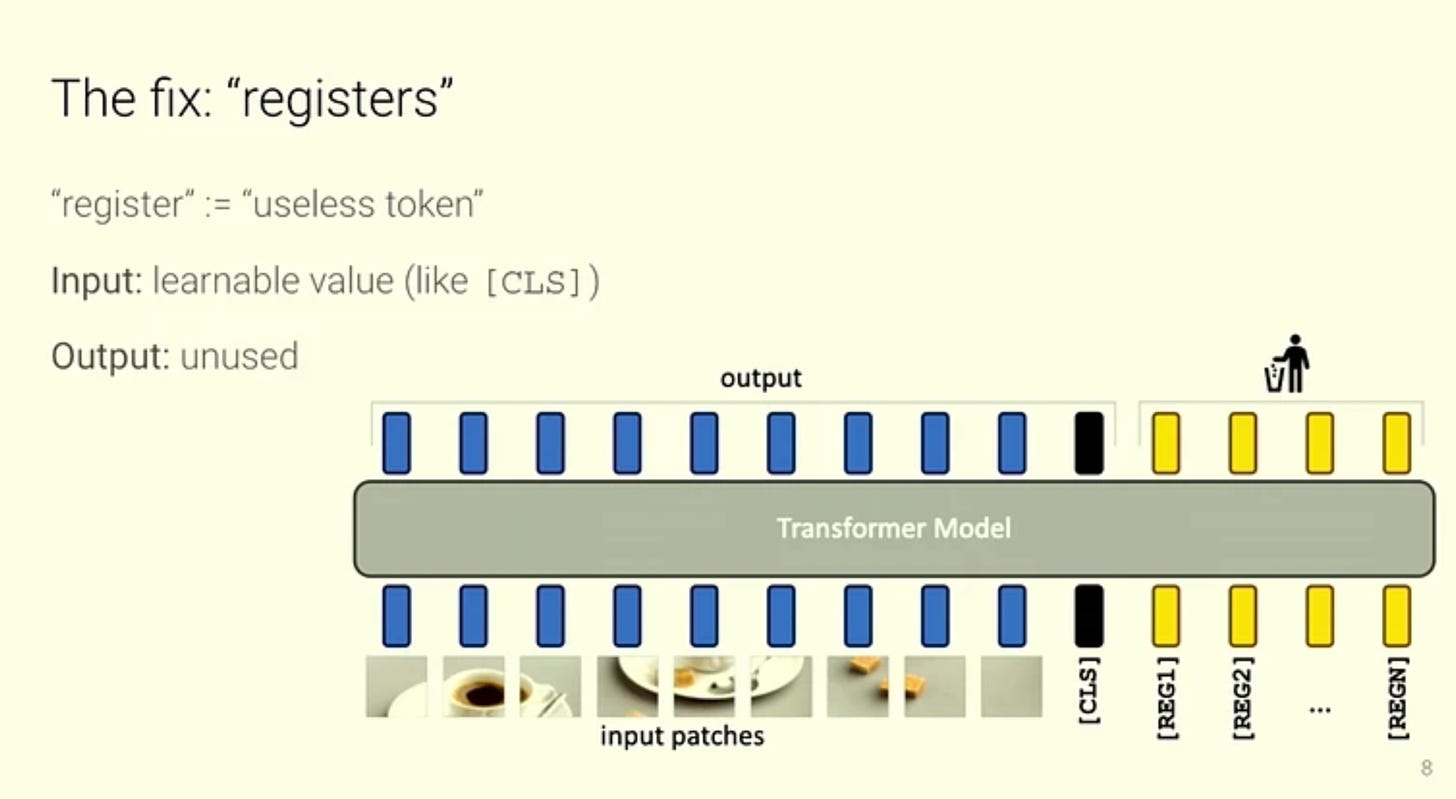

Тимоти Дарсет (Мета) гэх мэт: Алсын хараа хувиргагчдад бүртгэл хэрэгтэй ( ICLR аман , Цаас )

-

ICLR шилдэг цаасны шагнал : “Энэ баримт бичигт тодорхойлогдсон мэдээлэл багатай дэвсгэр хэсэгт өндөр норм бүхий жетоноор тодорхойлогддог харааны трансформаторын сүлжээний газрын зураг дээрх олдворууд . Зохиогчид яагаад ийм зүйл болж байгаа талаар гол таамаглал дэвшүүлж, эдгээр олдворуудыг ашиглах энгийн хэрнээ гоёмсог шийдлийг өгдөг. нэмэлт бүртгэлийн жетон, янз бүрийн ажил дээр загварын гүйцэтгэлийг сайжруулах . Энэ ажлаас олж авсан ойлголт нь бусад хэрэглээний талбарт ч нөлөөлж болно. Энэхүү баримт бичиг нь маш сайн бичигдсэн бөгөөд судалгаа хийх гайхалтай жишээг харуулж байна - асуудлыг тодорхойлох, яагаад ийм зүйл болж байгааг ойлгох, дараа нь шийдвэрлэх арга зам юм."

-

HN хэлэлцүүлэг : “Цаасан дээр дурдсанаар "бүртгэл" нь нэмэлт сурах боломжтой жетон сургалтын явцад Vision Transformer загварын оролтын дараалалд хавсаргасан болно. Тэдгээрийг [CLS] токентой төстэй сурах боломжтой үнэ бүхий нөхөөсийн давхаргын дараа нэмж, дараа нь Vision Transformer-ийн төгсгөлд бүртгэлийн жетоныг хаяж, зөвхөн [CLS] токен болон нөхөөсийн жетоныг зургийн дүрслэл болгон ашигладаг.

Бүртгэлийн жетонууд нь энэ үүрэгт нөхөөсийн жетоныг өөрчлөхгүйгээр урагшлах дамжуулалтын үеэр дэлхийн мэдээллийг хадгалах, боловсруулах, олж авах боломжийг олгодог.

Бүртгэлийн жетон нэмэх нь бэлтгэгдсэн Vision Transformer загваруудын онцлог газрын зураг дээр гарч ирэх олдворууд болон өндөр хэвийн "гадна" жетоныг устгадаг. Бүртгэлийн жетон ашиглах нь илүү зөөлөн функциональ газрын зураг, нягт урьдчилан таамаглах даалгаврын гүйцэтгэлийг сайжруулж, нэмэлт бүртгэлийн жетонгүйгээр бэлтгэгдсэн ижил загваруудтай харьцуулахад хараа хяналтгүй объектыг илүү сайн илрүүлэх боломжийг олгодог. Энэ бол цэвэр үр дүн юм. Дүгнэлт хийх зардлыг ердөө 2%-иар нэмэгдүүлснээр та ViT загварын гүйцэтгэлийг мэдэгдэхүйц сайжруулах боломжтой . Үнэгүй өдрийн хоолонд ойрхон."

-

Холбогдох: Sachin Goyal (Google) нар : Ярихаасаа өмнө бодоорой: Түр зогсоох тэмдэг бүхий хэлний загваруудыг сургах

-

-

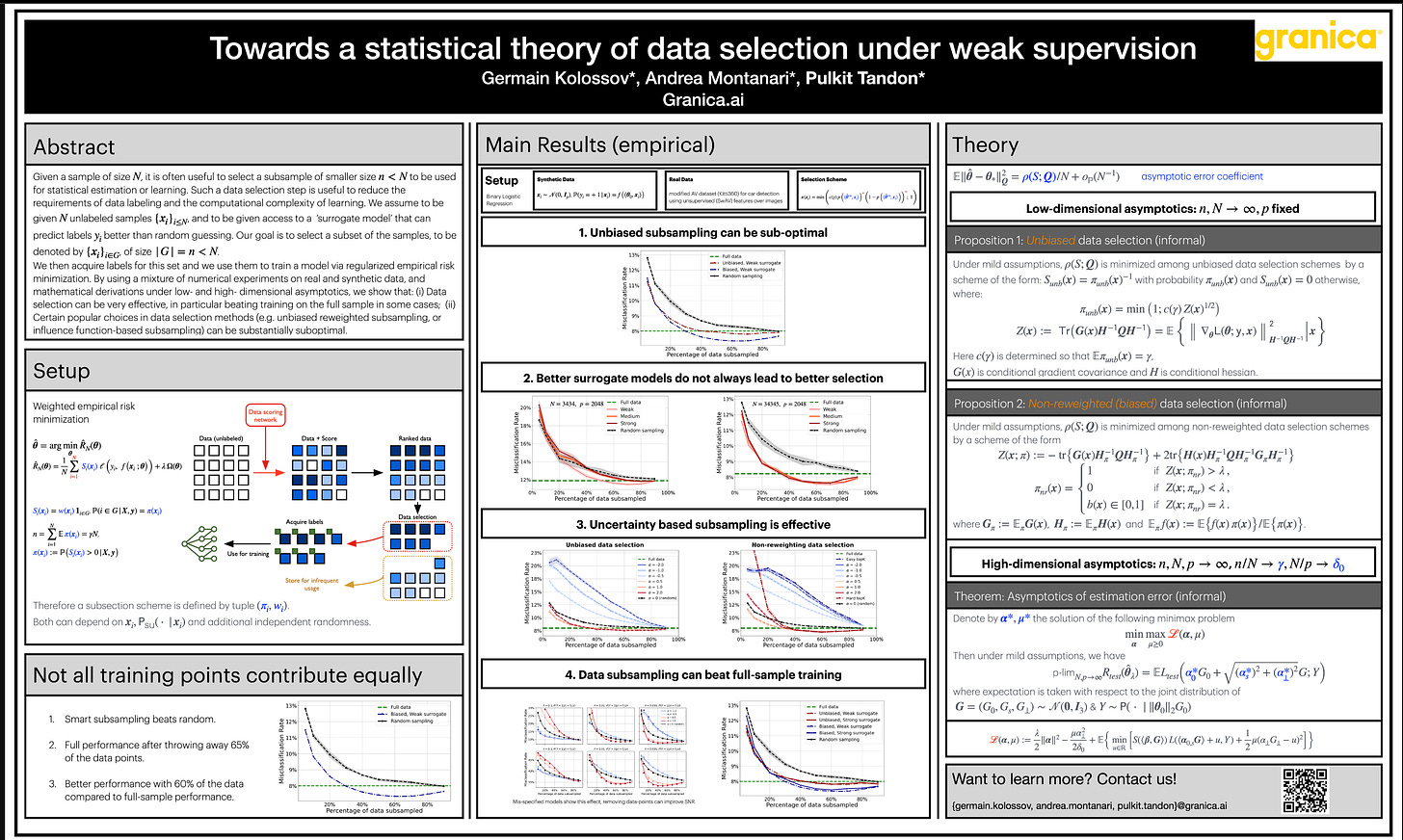

Жермен Колоссов (Граника) нар : Сул хяналт дор өгөгдөл сонгох статистикийн онол руу ( ICLR Oral , Зурагт хуудас , Цаас )

-

Хүндэт өргөмжлөл: “Цаас нь тогтоодог өгөгдлийн дэд багцыг сонгох статистикийн үндэс алдартай өгөгдөл сонгох аргуудын дутагдлыг тодорхойлдог."

-

-

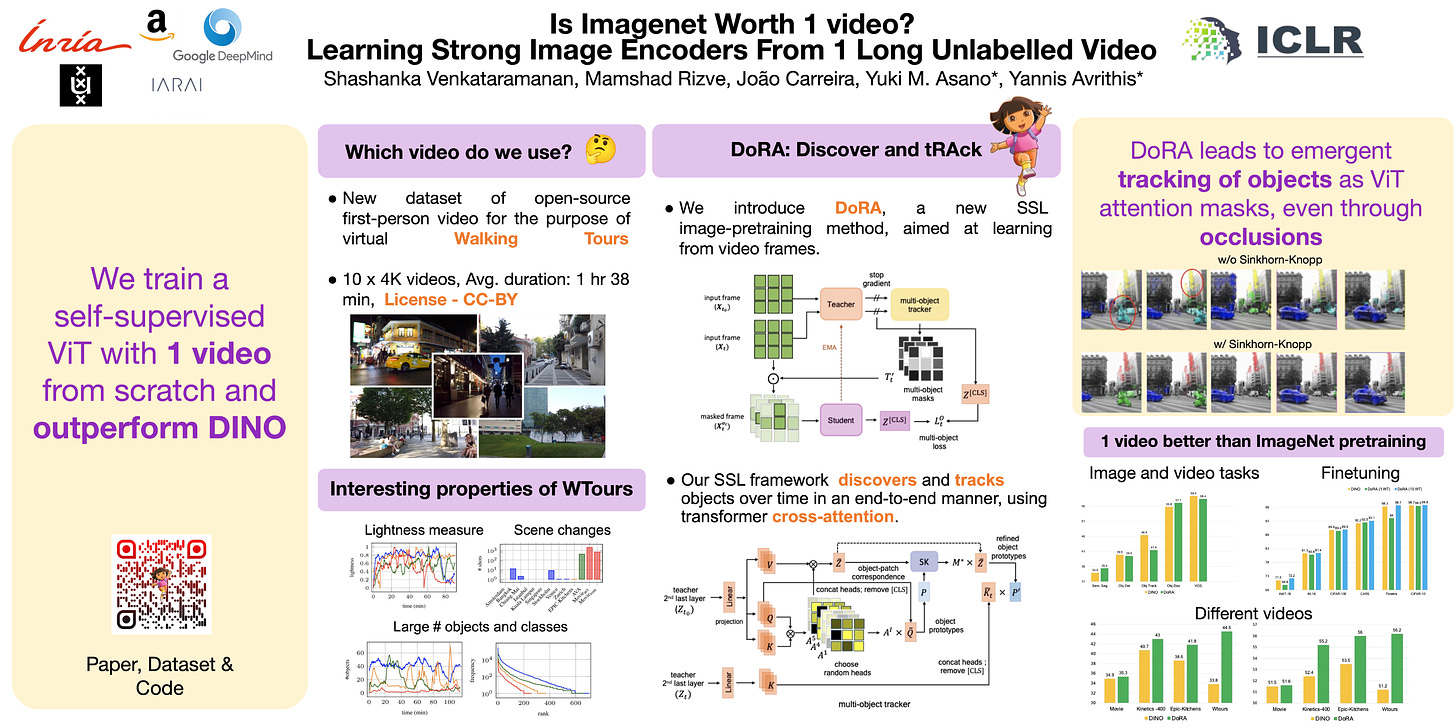

Shashank Venkataramanan (Inria) et al : ImageNet 1 видео үнэ цэнэтэй юу? 1 урт шошгогүй видеоноос хүчтэй зургийн кодлогч сурах ( ICLR Oral , цаас )

-

Эхлээд бид анхны хүний видеог судалж, "Алхах аялал" мэдээллийн багцыг танилцуулах . Эдгээр видеонууд нь өндөр нарийвчлалтай, хэдэн цаг үргэлжилдэг, байгалийн үзэгдлийн шилжилттэй олон тооны объект, үйлдлүүдийг дүрсэлсэн, тасралтгүй нэг удаагийн зураг авалтад баригдсан. Эдгээр нь шошгогүй, арчилгаагүй тул өөрийгөө хянах бодитой бөгөөд хүний сурлагатай харьцуулах боломжтой юм.

-

Хоёрдугаарт, бид тасралтгүй видео бичлэгээс суралцахад тохирсон, өөрөө удирддаг дүрсийг дүрслэх шинэ аргыг танилцуулж байна. Одоо байгаа аргууд нь ихэвчлэн зураг дээр суурилсан урьдчилан сургах арга барилыг илүү олон хүрээг багтаахын тулд тохируулдаг. Үүний оронд бид "таниж сурахын тулд хянах" аргыг дэмждэг. Манай аргыг дуудсан DoRA нь трансформаторын хөндлөнгийн анхаарлыг ашиглан DiscOver болон tRAck объектуудыг цаг хугацааны явцад эцэс төгсгөлгүй байдлаар харуулсан анхаарлын газрын зураг руу хөтөлдөг. . Бид замаас олон удаа үзэл бодлыг олж авч, тэдгээрийг сонгодог өөрөө удирддаг нэрэх алдагдалд ашигладаг. Манай шинэ аргыг ашиглан, Ганц Walking Tours видео нь ImageNet-ийн хэд хэдэн зураг, видео бичлэгийн доод талын ажилд хүчтэй өрсөлдөгч болдог.

-

Эрхэм өргөмжлөл : “Цаас нь шинэ замыг санал болгож байна тасралтгүй видео бичлэгээс суралцах замаар өөрөө удирддаг дүрсийг урьдчилан сургах . Энэхүү баримт бичиг нь шинэ төрлийн өгөгдөл болон шинэ өгөгдлөөс суралцах аргыг хоёуланг нь хувь нэмэр оруулдаг."

-

C: Трансформатор ба анхаарлыг өргөжүүлэх

-

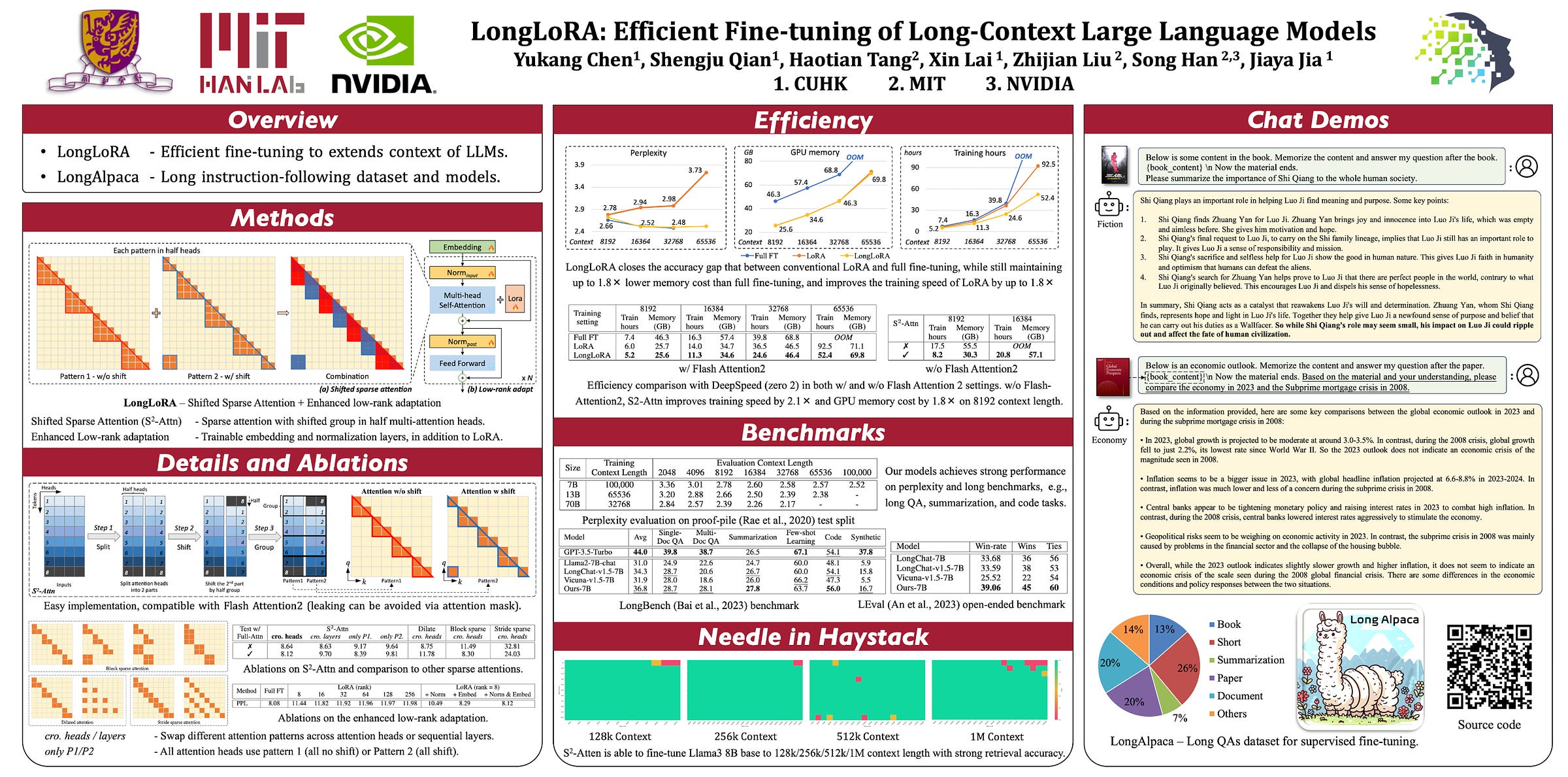

Юкан Чен (CUHK) гэх мэт: LongLoRA: Урт контекст том хэлний загваруудын үр дүнтэй нарийн тохируулга ( ICLR Oral , Зурагт хуудас )

-

Бид танилцуулж байна LongLoRA , тооцооллын зардал хязгаарлагдмал, урьдчилан бэлтгэгдсэн том хэлний загваруудын (LLMs) контекст хэмжээг өргөтгөх үр ашигтай нарийн тохируулах арга. LongLoRA нь өргөтгөдөг Лама2 7Б 4к контекстээс 100к хүртэл , эсвэл Лама2 70Б-аас 32к хүртэл нэг 8х A100 машин дээр . LongLoRA нь анхны архитектурыг хадгалахын зэрэгцээ загваруудын контекстийг өргөжүүлдэг бөгөөд Flash-Attention2 гэх мэт одоо байгаа ихэнх техниктэй нийцдэг.

-

-

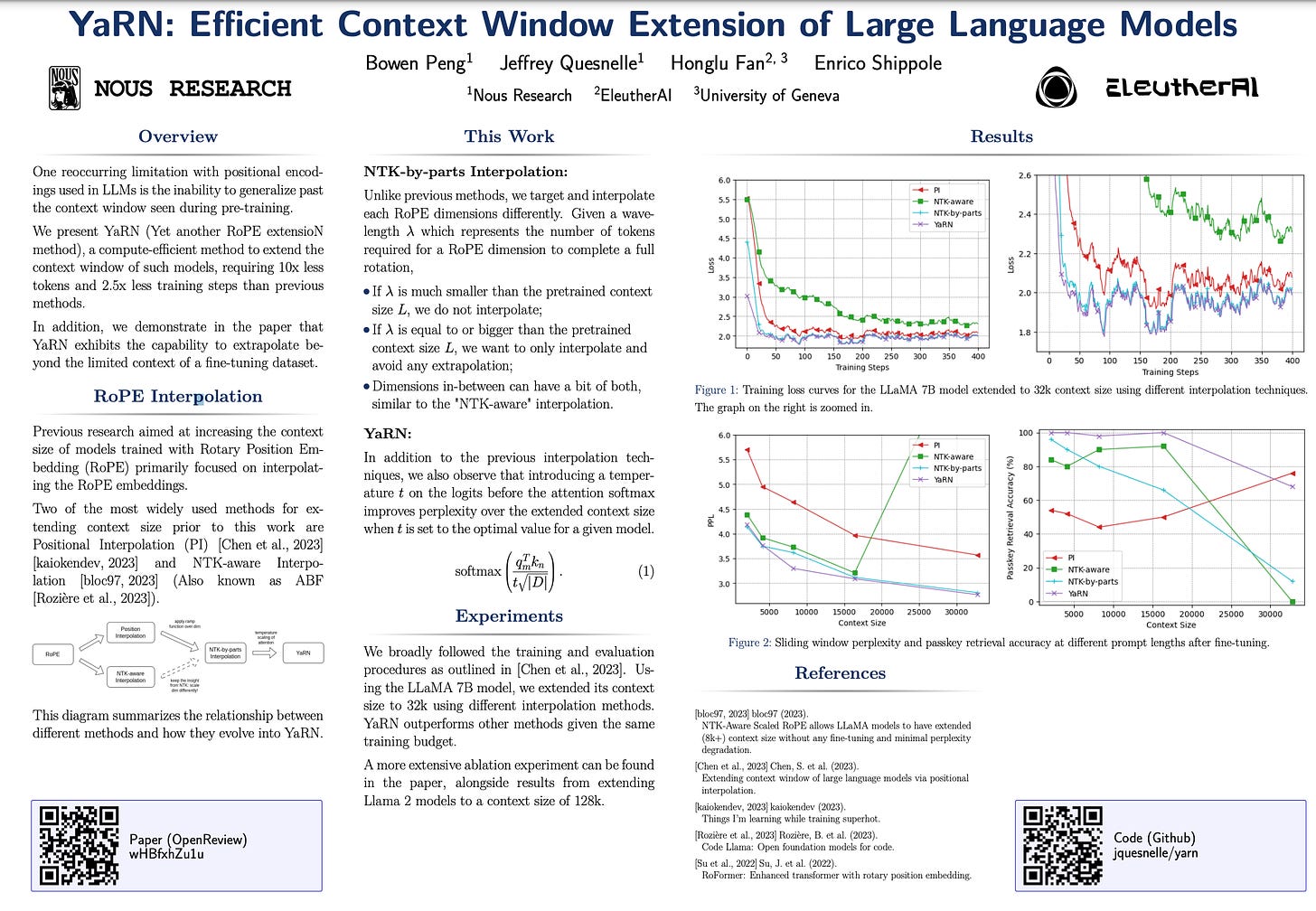

Bowen Peng (Nous Research) нар : YaRN: Том хэлний загваруудын үр дүнтэй контекст цонхны өргөтгөл ( Зурагт хуудас , Цаас )

-

Rotary Position Embeddings (RoPE) нь трансформаторт суурилсан хэлний загварт байрлалын мэдээллийг үр дүнтэй кодлодог болохыг харуулсан. Гэсэн хэдий ч эдгээр загварууд нь сургасан дарааллын хугацааг ерөнхийд нь дүгнэж чаддаггүй. Бид танилцуулж байна YaRN (Гэсэн хэдий ч өөр нэг RoPE өргөтгөлийн арга) , ийм загваруудын контекст цонхыг өргөтгөх тооцооллын үр ашигтай арга, 10 дахин бага жетон, 2.5 дахин бага сургалтын алхам шаарддаг өмнөх аргуудаас илүү. YaRN-ийг ашигласнаар бид LLaMA загварууд үр дүнтэй болохыг харуулж байна анхны бэлтгэл сургуулилтаас хамаагүй урт контекст уртад ашиглах, экстраполяци хийх , мөн контекст цонхны өргөтгөлийн хамгийн сүүлийн үеийн загвараас давсан. Нэмж дурдахад, YaRN нь нарийн тааруулах өгөгдлийн багцын хязгаарлагдмал контекстээс гадуур экстраполяци хийх чадвартайг бид харуулж байна. YaRN ашиглан нарийн тохируулсан загваруудыг онлайнаар ашиглах боломжтой болгож, хуулбарласан 128к хүртэлх контекст урт.

-

Дурдсан баримтууд: Kaikoendev SuperHOT бэлтгэл хийж байхдаа TILs дээр , LongRoPE , Бөгжний анхаарал , Инфини Анхаар , Сурах бичиг л танд хэрэгтэй болон синтетик өгөгдлийн асуудал

-

-

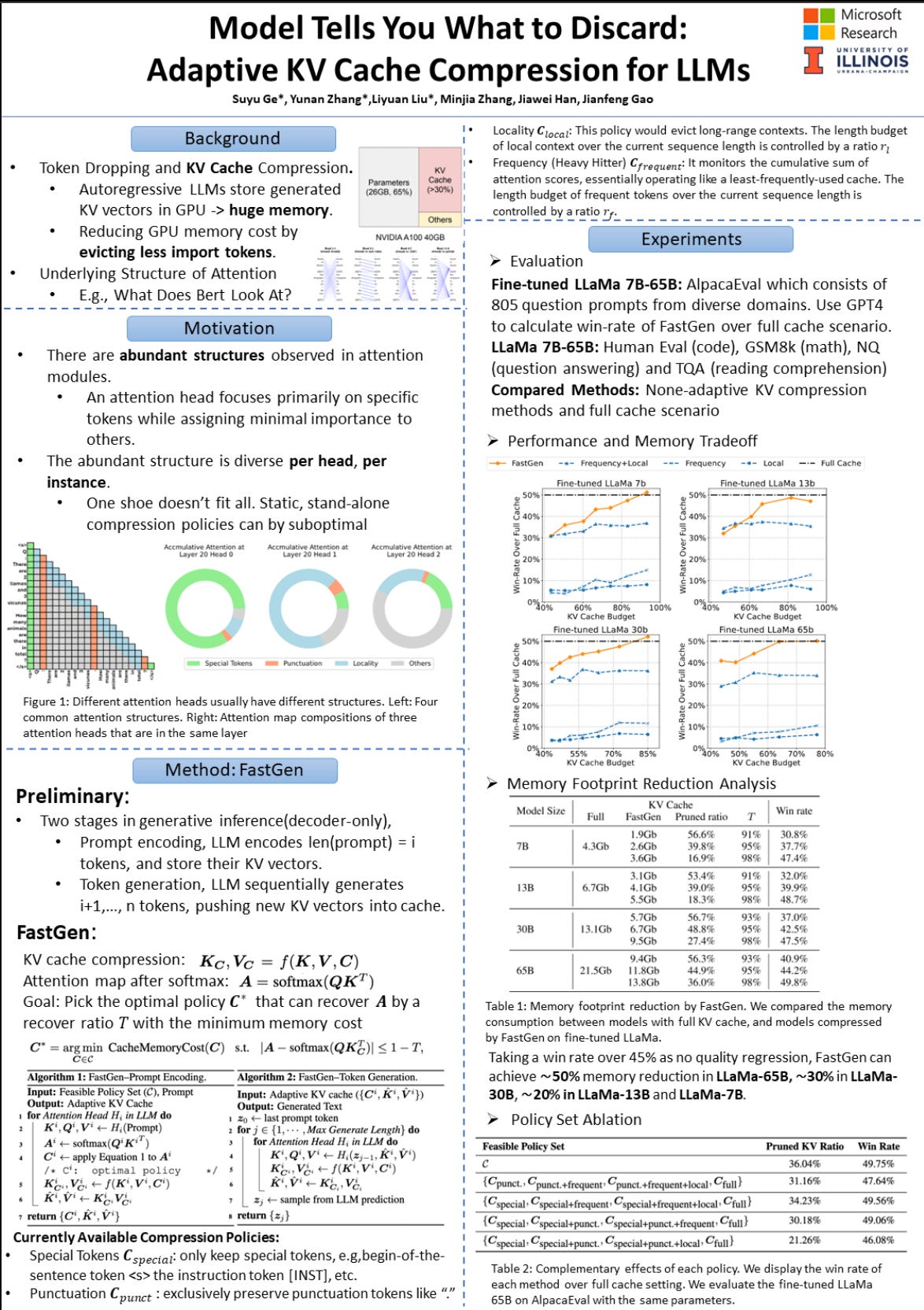

Suyu Ge et al : Загвар өмсөгч танд юуг хаяхыг хэлж байна: LLM-д зориулсан дасан зохицох KV кэшийн шахалт (FastGen гэх мэт. ICLR Oral , Зурагт хуудас , Цаас)

-

“Бид танилцуулж байна дасан зохицох KV кэш шахах , Том хэлний загваруудын (LLMs) үүсгэгч дүгнэлтийн санах ойн ул мөрийг бууруулдаг залгуур ба тоглуулах арга. Бүх контекст жетоны түлхүүр болон утгын векторуудыг хадгалдаг ердийн KV кэшээс ялгаатай нь бид явуулдаг Анхаарлын модулиудын дотоод бүтцийг ялгахад чиглэсэн профайл . Хүлээн зөвшөөрөгдсөн бүтэц дээр үндэслэн бид KV кэшийг дасан зохицох аргаар бүтээнэ: алсын зайн контекстийг нүүлгэн шилжүүлэх орон нутгийн нөхцөл байдлыг онцолсон анхаарлын тэргүүнүүд дээр, тусгай бус жетон хаях тусгай жетон дээр төвлөрсөн анхаарлын толгой дээр, зөвхөн бүх жетонд өргөн анхаарал хандуулдаг анхааралд зориулсан стандарт KV кэшийг ашигладаг. Төрөл бүрийн асуултуудад хийсэн туршилтууддаа, FastGen нь GPU-ийн санах ойн хэрэглээг мэдэгдэхүйц бууруулж, үеийн чанарын алдагдал багатай байгааг харуулж байна .'

-

Ламагийн санах ойг 40% бууруулах 67b

-

Эрхэм өргөмжлөл : “Цаас нь зорилтот KV кэш шахалтын чухал асуудал трансформаторт суурилсан LLM-д маш их нөлөө үзүүлж, нөөц их шаарддаг нарийн тааруулах, дахин сургахгүйгээр ашиглах боломжтой энгийн санаагаар санах ойг багасгах . Энэ арга нь маш энгийн боловч нэлээд үр дүнтэй болохыг харуулж байна."

-

-

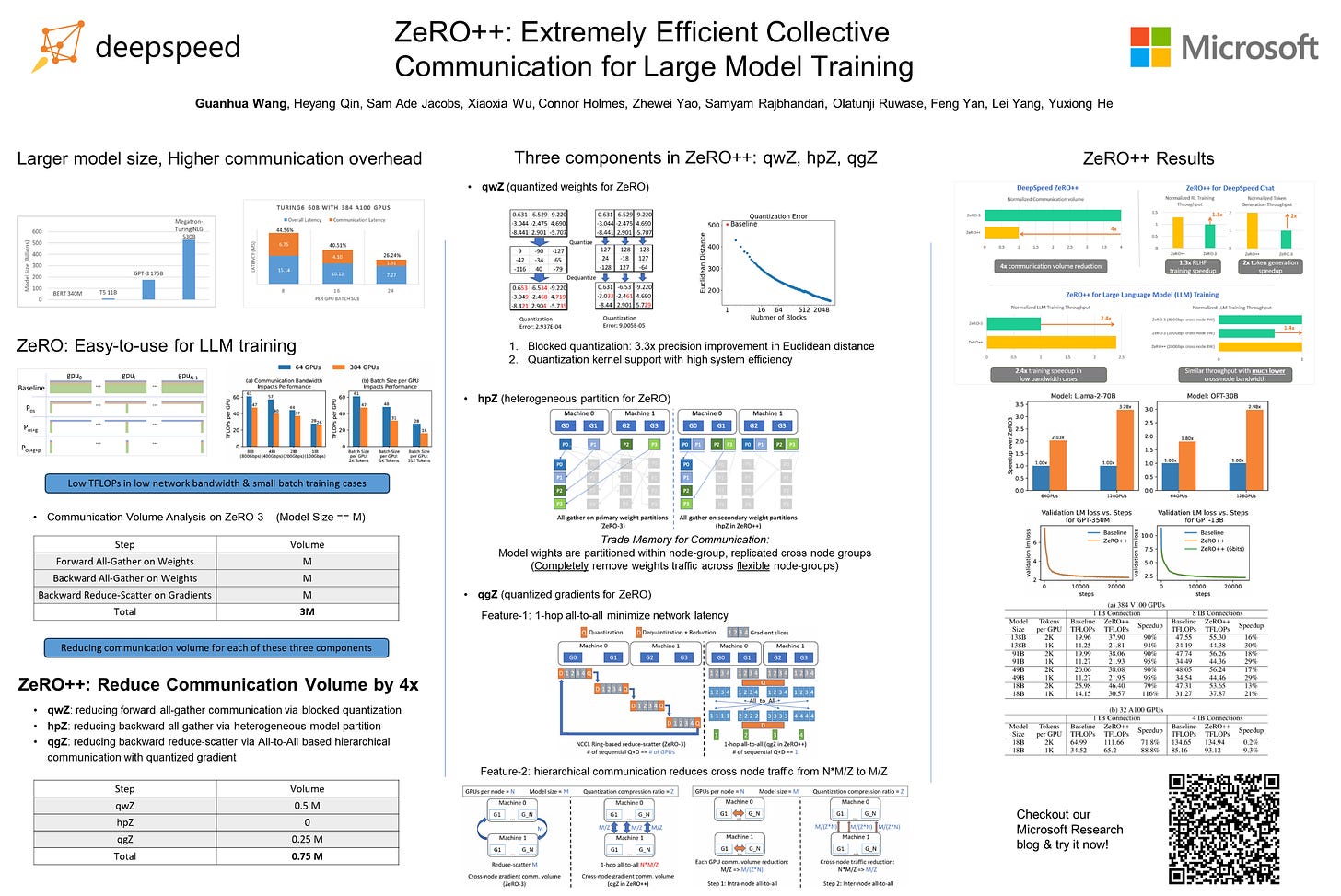

Гуанхуа Ван (DeepSpeed) нар , ZeRO++: Аварга загвар сургалтын маш үр дүнтэй хамтын харилцаа холбоо ( цаас , зурагт хуудас , блог нийтлэл )

-

Zero Redundancy Optimizer (ZeRO) ашиглахад хялбар, үр ашигтай, өргөтгөх чадвар сайтай тул GPU-ийн асар том кластерууд дээр өргөн хүрээний том хэлний загваруудыг сургахад ашигласан. Гэсэн хэдий ч бага зурвасын өргөнтэй кластерууд дээр сургалт явуулах, эсвэл GPU-д ногдох багцын хэмжээг бага байлгахад хүргэдэг масштабаар ZeRO-ийн үр дүнтэй нэвтрүүлэх чадвар нь урагш дамжуулалт, арагш дамжуулалт, дундаж градиент дээр жин цуглуулахаас өндөр харилцааны эзэлхүүнээс шалтгаалан хязгаарлагдмал байдаг. Энэхүү баримт бичиг нь дамжуулалтыг нэвтрүүлж байна. харилцааны хэмжээг бууруулах гурван арга , бид хамтдаа ZeRO++ гэж нэрлэдэг бөгөөд ZeRO дахь харилцааны нэгдэл бүрийг чиглүүлдэг.

-

Хамтдаа ZeRO++ нь ZeRO-ийн холбооны хэмжээг 4 дахин бууруулж, 384 GPU масштабаар 2.16x хүртэл илүү сайн дамжуулах чадварыг идэвхжүүлдэг.

-

-

Дурдсан: FSDP + QLoRA

Зурагт хуудасны хуралдаан сонгох

Эдгээрийг подкастад оруулахын тулд бидний эфирийн цаг дууссан ч бид эдгээр зохиолчдын заримтай хийсэн ярилцлагыг бичиж, хүсэлтийн дагуу аудио хуваалцах боломжтой болсон.

-

Хураангуй

-

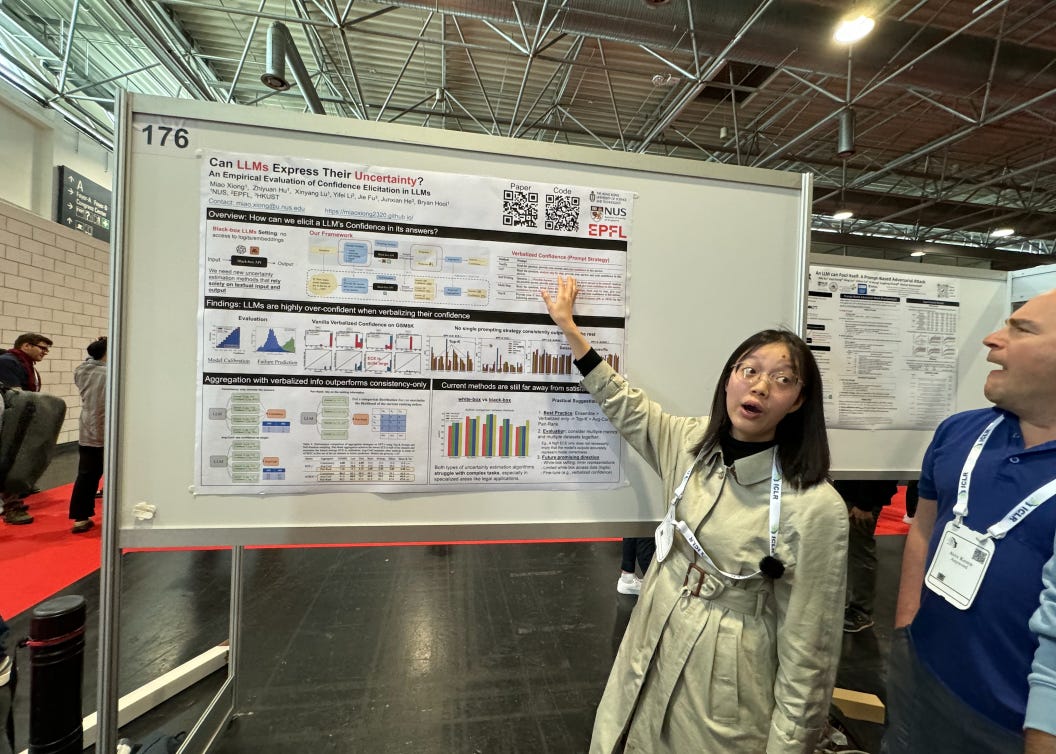

Тодорхойгүй байдал

-

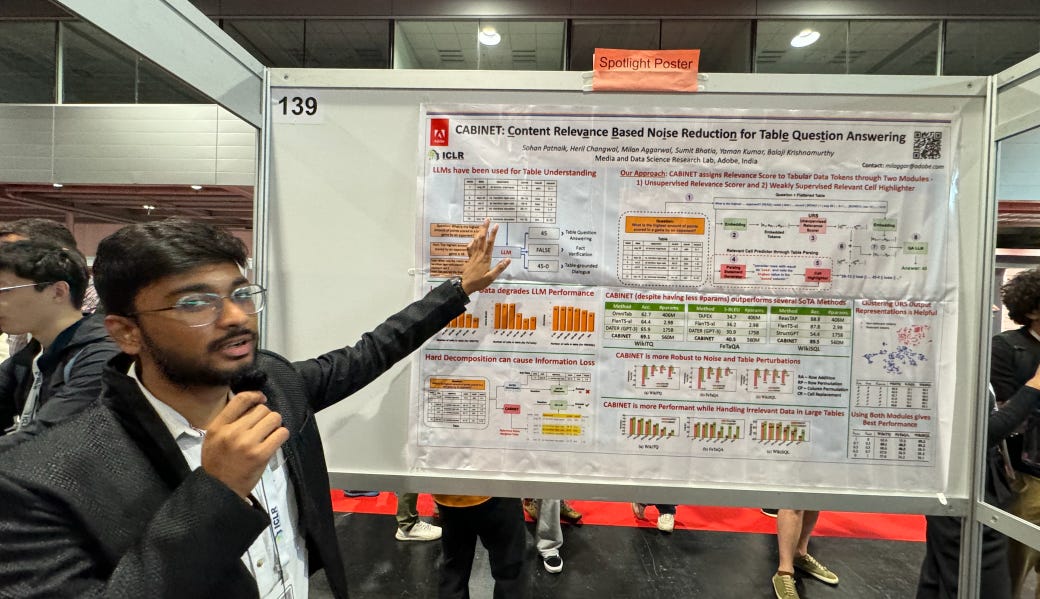

Хүснэгийн өгөгдөл

-

Усны тэмдэглэгээ (усны тэмдэглэгээний талаар >24 баримт бичиг байсан, дэмжсэн болон эсэргүүцсэн!!)

-

Миск

D: Төрийн сансрын загварууд ба трансформаторууд

-

Саша Рашийн улсын сансрын загварууд ICLR урьсан яриа семинарын өдөр

-

Ido Amos (IBM) нар : Scratch-аас хэзээ ч сургадаггүй: Урт дарааллын загваруудын шударга харьцуулалт нь өгөгдөлд тулгуурласан приоруудыг шаарддаг ( ICLR Oral )

-

Дараалал хоорондын алсын зайн хамаарлыг загварчлах нь машин сургалтын урт хугацааны зорилго бөгөөд улсын сансрын загвар гэх мэт архитектурыг урт дараалал дээр Transformers-ээс эрс давж гарахад хүргэсэн.

-

Гэсэн хэдий ч эдгээр гайхалтай эмпирик ололтыг загваруудыг санамсаргүй байдлаар эхлүүлж, оролтын дарааллаас зорилтот шошгыг урьдчилан таамаглахад сургадаг жишиг үзүүлэлтүүд (жишээ нь, Long Range Arena) дээр харуулсан. Энэ ажилд бид үүнийг харуулж байна санамсаргүй байдлаар эхлүүлэх нь архитектурын ялгааг хэт үнэлэхэд хүргэдэг .

-

Өмнөх бүтээлүүдээс эрс ялгаатай нь бид олдог ванилийн трансформаторууд нь зохих ёсоор бэлтгэгдсэн үед Long Range Arena дээрх S4-ийн гүйцэтгэлтэй таарах болно , мөн бид PathX-256 даалгаврын SSM-ийн хамгийн сайн тайлагнасан үр дүнг 20 үнэмлэхүй оноогоор сайжруулдаг.

-

Дараа нь бид SSM-д өмнө нь санал болгож байсан бүтэцлэгдсэн параметрүүдийн ашиг тусыг шинжилж, урьдчилсан сургалтаар олж авсан өгөгдөлд суурилсан эхлүүлэх үед тэдгээр нь ихэвчлэн илүүдэхгүй болохыг харуулж байна. Хяналттай даалгаврын янз бүрийн архитектурыг үнэлэхдээ урьдчилан сургах замаар өгөгдөлд тулгуурласан прайперуудыг нэгтгэх нь гүйцэтгэлийн найдвартай тооцоололд зайлшгүй шаардлагатай бөгөөд үр дүнтэй хийх боломжтойг бидний ажил харуулж байна.

-

Шилдэг цаасан шагнал : “Энэ баримт бичиг нь саяхан санал болгож буй төрийн сансрын загварууд болон трансформаторын архитектуруудын урт хугацааны дараалсан хамаарлыг загварчлах чадварыг ойлгоход гүн гүнзгий шумбаж байна. Гайхалтай нь зохиогчид үүнийг олж мэдсэн. Трансформаторын загваруудыг эхнээс нь сургах нь тэдний гүйцэтгэлийг дутуу үнэлэхэд хүргэдэг Сургалтын өмнөх болон нарийн тохируулга хийснээр гайхалтай үр дүнд хүрч болохыг харуулж байна. Энэхүү баримт бичиг нь маш сайн хийгдсэн бөгөөд энгийн байдал, системтэй ойлголтод анхаарлаа төвлөрүүлснээрээ үлгэр жишээ юм."

-

Хэрэв танд үүнийг ажиллуулахын тулд илүү их хөнгөлөлт хэрэгтэй бол купон ашиглаарай

AINEWS.